快手评论区里蕴含着好多用户确实存在的反馈,这些数据对于市场剖析以及舆情监测有着关键意义。可是呢,凭借技术办法自动化收集这些数据也引发了围绕用户隐私和数据安全的热烈讨论。

数据采集的技术基础

计算机程序模拟浏览器行为是网络数据采集所依赖的,Python语言的requests库可发送HTTP请求,它成为数据采集优选工具是因为其语法简洁且功能强大,开发者要在代码里设置请求头信息,其中涵盖User-Agent字段,这是模拟真实浏览器访问的必要步骤。

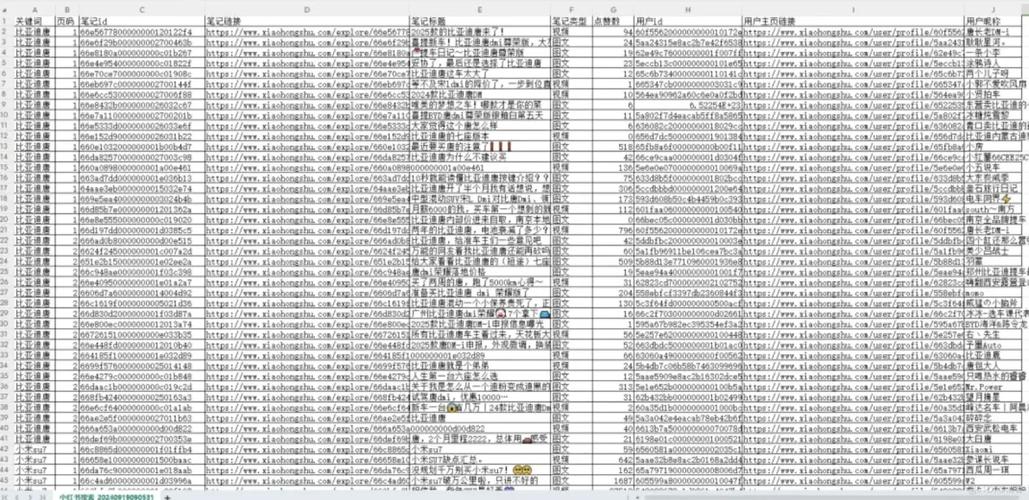

于实际操作当中,程序要构造完整的请求参数,以快手评论区作例子,采集之际要指定视频ID、起始位置等关键参数,服务器接收到合法请求之后,会返回结构化数据,通常是以JSON格式进行传输,这种格式利于程序解析以及处理。

API接口的工作原理

程序间通信桥梁是应用程序接口体现,数据访问服务标准化是快手平台借助API来供给的,特定网络地址里存在着快手平台的评论接口,参数格式有分页参数和身份验证信息,这是平台规定范围内请求接口应遵循的 。

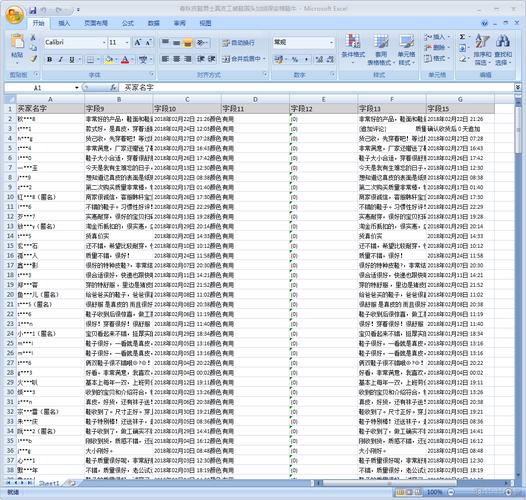

服务器针对每个请求,都会返回状态码,其中200代表成功,而其他代码意味着各类错误,成功获取的数据,通常涵盖评论内容、用户信息、点赞数等字段,这些数据依照特定结构组织,需逐层解析方可提取有效信息。

数据解析的技术实现

网络数据传输的主流格式是JSON,其层次化结构能高效存储复杂数据,在Python里,内置的json模块可直接把JSON字符串转换为字典对象,便于程序进一步处理,评论数据通常存于特定的字典键下,需准确定位。

BeautifulSoup是致力于解析HTML以及XML文档的Python库哟,倘若评论内容涵盖HTML标签,应用这个库能够飞速提取纯文本啦,它给出好多查找方法呢,能够精细定位目标内容,促使数据提取的精确性得以保证呀。

实时采集的系统设计

实时数据采集快手点赞自助平台,得要建立起持续运行着的监控机制。借助循环结构,配合延时控制,如此便能达成定期数据抓取。于Python当中,time模块的sleep函数,能够达成程序暂停,防止频繁请求给服务器带去压力。

这个工作需要系统具备异常处理机制,以应对网络出现波动,或是服务器发生错误等状况。完善的日志记录功能,对监控程序运行状态是有帮助的。合理地设置间隔时间能够保证数据及时性,并且不会过度消耗系统资源。

数据处理的注意事项

原始数据被采集到后,要经过清洗以及整理,这其中涵盖去除重复内容,还有过滤无效字符,也包括统一编码格式等步骤,规范的数据预处理能够显著提升后续分析的准确性。

数据存储之际,要挑选适宜的形式,文本文件适配小规模数据,数据库利于处理大量记录。鉴于数据安全性,关键信息得定期备份。并且,数据处理进程要契合相关法律法规的规定。

合规使用的边界

必须遵守《网络安全法》以及《个人信息保护法》等法律法规,这是数据采集行为应遵循的。平台的服务协议明确规定了数据使用范围,超出许可范围的采集,有可能构成侵权。2021年国家网信办发布了《互联网用户公众账号信息服务管理规定》快手点赞自助平台,该规定对数据采集提出了明确要求。

以商业目的进行的数据采集,需获取对应的授权,个人开展研究时亦应该留意尺度,建议在进行采集之前向法律专业人士咨询,以此保证程序设计以及数据使用均处于合法的范围之内,技术开发者理应树立起数据伦理意识,平衡技术创新与社会责任之间的关系。

所有的人于数据采集进程期间碰到过什么样的合规性方面的挑战呢,欢迎于评论区域分享您所拥有的经验,要是感觉此文章具备帮助作用,请进行点赞给予支持。

抖音网站0.5块钱100个

抖音网站0.5块钱100个